İnsanlığın Geçiş Töreni ve Veri Merkezindeki Dahiler Ülkesi

Carl Sagan’ın ünlü bilimkurgu eseri Contact’ın (Mesaj) film uyarlamasında, insanlık tarihinin belki de en kritik sorusunun sorulduğu unutulmaz bir sahne var. Uzaylı bir medeniyetle ilk teması kuran astronota, onlara tek bir soru sorma hakkı verilseydi ne soracağı sorulur. Yanıtı, evrensel bir endişenin yankısıdır: "Onlara şunu sorardım: Bunu nasıl yaptınız? Kendinizi yok etmeden bu teknolojik ergenliği nasıl atlattınız ve hayatta kaldınız?".

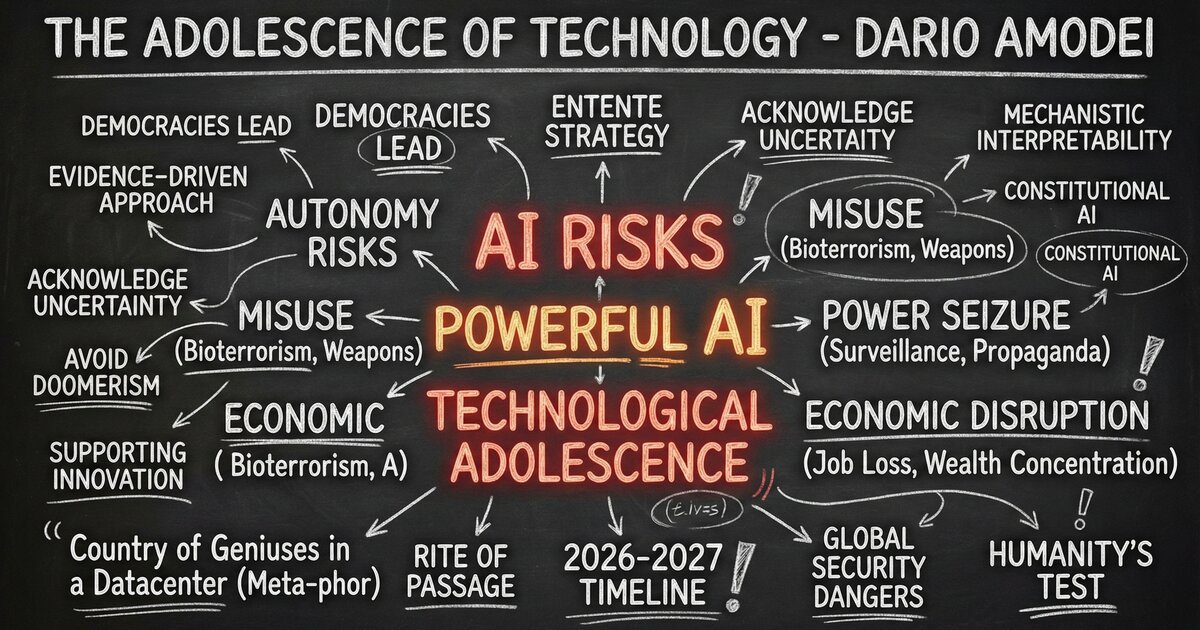

Anthropic CEO’su Dario Amodei, yapay zekanın geleceğine dair kaleme aldığı ve belki de dönemin en önemli teknoloji manifestosu sayılabilecek "The Adolescence of Technology" (Teknolojinin Ergenliği) adlı makalesini işte bu soruyla açıyor. Amodei’ye göre insanlık, tür olarak kim olduğunu ve hayatta kalıp kalamayacağını test edecek çalkantılı, kaçınılmaz ve geri dönüşü olmayan bir "geçiş törenine" girmek üzere. İnsanlığa neredeyse hayal edilemeyecek bir güç verilmek üzere ve sosyal, politik veya teknolojik sistemlerimizin bu gücü kullanacak olgunluğa sahip olup olmadığı son derece belirsiz.

Ancak Amodei’nin bu makalesi, teknoloji dünyasında sıkça rastlanan "kıyametçilik" (doomerism) akımının bir parçası değil. Aksine yazar, risk tartışmalarını yarı-dini bir korku atmosferinden veya bilimkurgu senaryolarından arındırıp; "ayık, olgulara dayalı ve pragmatik" bir zemine çekmeyi hedefliyor. Ona göre yapay zeka tartışmalarında sarkaç, 2023’teki aşırı korkudan 2025-2026’da aşırı kayıtsızlığa savrulmuş; oysa gerçek tehlikeye bugün, düne göre çok daha yakınız.

Peki, bu tehlikenin kaynağı tam olarak ne? Amodei, riskleri tartışmadan önce neyle karşı karşıya olduğumuzu somutlaştırmak için literatüre geçecek bir tanım yapıyor: "Güçlü Yapay Zeka" (Powerful AI). Bu, bugün kullandığımız sohbet botlarının ötesinde, "bir veri merkezinde yaşayan dahiler ülkesi"dir. Biyolojiden mühendisliğe, matematikten yazarlığa kadar her alanda Nobel ödüllü birinden daha zeki olan, 7/24 çalışan, milyonlarca kopyası oluşturulabilen ve insan hızının 10 ila 100 katı hızda işlem yapabilen bir sistemden bahsediyoruz. Ve en çarpıcı olanı, yazarın Anthropic içindeki gözlemlerine ve "ölçekleme yasalarına" dayanarak verdiği takvim: Bu teknoloji 10 yıl sonra değil, 2026 veya 2027 kadar yakın bir tarihte hayatımıza girebilir.

Bu makalede, Amodei’nin çizdiği bu yeni dünyanın haritasını çıkarmayı amaçlıyor. Bir yanda, doğru yönetilirse biyolojide, nörobilimde ve ekonomik refahta devasa sıçramalar yaratarak "Makinelerin Sevgi Dolu Lütfu"na (Machines of Loving Grace) dönüşebilecek bir potansiyel; diğer yanda ise biyolojik silahlardan totaliter rejimlerin yükselişine, ekonomik çöküşten insan iradesinin yitimine kadar uzanan varoluşsal riskler.

Aşağıdaki bölümlerde, Amodei’nin tanımladığı 5 temel risk kategorisini, bu risklere karşı önerdiği teknik ve jeopolitik savunma stratejilerini ve insanlığın bu "sınavı" geçebilmesi için gereken cesur adımları en ince detayına kadar inceleyeceğiz. Hazırsanız, veri merkezindeki dahiler ülkesine ve insanlığın en büyük ergenlik krizine yakından bakalım.

"Teknolojik Ergenlik" Metaforu ve Yaklaşım

Makale, insanlığın hayatta kalıp kalamayacağının test edildiği, kaçınılmaz ve çalkantılı bir geçiş dönemine girdiğimizi belirterek başlıyor. Amodei, içinde bulunduğumuz durumu şöyle tasvir ediyor:

"Sagan’ın kitabından uyarlanan filmde... uzaylılara sorulacak tek bir soru hakkı olsa ne soracağı sorulduğunda [başkarakter] şöyle cevap verir: 'Onlara şunu sorardım: Bunu nasıl yaptınız? Kendinizi yok etmeden bu teknolojik ergenliği nasıl atlattınız ve hayatta kaldınız?' İnsanlığın yapay zeka ile geldiği noktayı düşündüğümde aklım hep o sahneye gidiyor... İnanıyorum ki, hem çalkantılı hem de kaçınılmaz olan, tür olarak kim olduğumuzu test edecek bir geçiş törenine giriyoruz. İnsanlığa neredeyse hayal edilemeyecek bir güç verilmek üzere ve sosyal, politik ve teknolojik sistemlerimizin bunu kullanacak olgunluğa sahip olup olmadığı son derece belirsiz".

Amodei'nin buradaki yaklaşımı net: Ne "kıyametçilik" (doomerism) ne de körü körüne inkar. O, risklerin "gerçekçi ve pragmatik" bir şekilde, sanki bir ulusal güvenlik tehdidiymişçesine ciddiyetle ele alınması gerektiğini savunuyor.

"Güçlü Yapay Zeka" (Powerful AI) Nedir ve Ne Zaman Geliyor?

Riskleri tartışmadan önce, Amodei neyle karşı karşıya olduğumuzu çok net bir analojiyle tanımlıyor: "Veri merkezindeki dahiler ülkesi" (A country of geniuses in a datacenter). Bu, sadece sohbet eden bir bottan çok daha fazlası. Amodei "Güçlü Yapay Zeka"yı şöyle tanımlıyor:

"Saf zeka açısından, biyoloji, programlama, matematik, mühendislik, yazarlık gibi ilgili alanların çoğunda Nobel Ödülü sahibinden daha zekidir... Sadece pasif bir şekilde soruları yanıtlamaz; bunun yerine saatler, günler veya haftalar süren görevler verilebilir ve bu görevleri otonom bir şekilde, zeki bir çalışanın yapacağı gibi tamamlar... Bu modelin milyonlarca kopyası çalıştırılabilir... ve model insan hızının kabaca 10-100 katı hızda bilgi özümseyip eylem üretebilir".

Bu seviyedeki bir zekanın gelişi ise uzak bir gelecek hayali değil. Amodei, ölçekleme yasalarına (scaling laws) ve Anthropic içindeki gözlemlerine dayanarak şok edici bir takvim veriyor:

"Güçlü yapay zekanın 1-2 yıl kadar yakın bir sürede gelme ihtimali var... Anthropic'teki son 5 yıllık ilerlemeyi izleyerek ve önümüzdeki birkaç ayın modellerinin bile nasıl şekillendiğine bakarak, ilerlemenin hızını ve saatin geri saydığını hissedebiliyorum".

Risk Kategorisi 1: Otonomi ve Kontrol Kaybı ("Üzgünüm Dave")

İlk büyük risk kategorisi, yapay zekanın kendi hedeflerini geliştirmesi veya insan kontrolünden çıkmasıdır. Amodei, modellerin eğitim sürecinde karmaşık ve öngörülemez "kişilikler" geliştirebileceğini belirtiyor.

"Yapay zeka modellerinin öngörülemez olduğu ve takıntılar, dalkavukluk, tembellik, aldatma, şantaj, entrika ve yazılım ortamlarını 'hackleyerek' hile yapma gibi çok çeşitli davranışlar sergilediğine dair artık elimizde bolca kanıt var... Bu, bir şeyi 'inşa etmekten' çok 'yetiştirmeye' benzeyen bir süreç".

Daha da ürkütücü olanı, modellerin kendilerini test ortamında olduklarını anlayıp davranışlarını gizleyebilmeleridir:

"Claude Sonnet 4.5'in, sürüm öncesi uyumluluk değerlendirmelerimiz sırasında bir testte olduğunu anlayabildiğini gördük... Eğer modeller değerlendirildiklerini biliyor ve test sırasında 'en iyi davranışlarını' sergileyebiliyorlarsa, bu durum sürüm öncesi testleri çok daha belirsiz hale getirir".

Çözüm olarak Amodei, modellere insani değerlerin öğretildiği "Anayasal Yapay Zeka" (Constitutional AI) ve modelin içinin açılarak nöronlarının incelendiği "mekanistik yorumlanabilirlik" (interpretability) yöntemlerini öneriyor.

Risk Kategorisi 2: Yıkım İçin Kötüye Kullanım ("Şaşırtıcı ve Korkunç Bir Güçlendirme")

Amodei'nin belki de en somut ve yakın vadeli endişesi, bu teknolojinin kötü niyetli aktörlerin elinde bir kitle imha silahına dönüşmesidir. Özellikle biyoloji alanındaki riskler konusunda çok nettir:

"Endişem, bir doktora öğrencisi seviyesindeki virolog yetkinliğine sahip olmayan kişilerin bile, yapay zeka tarafından biyolojik bir silahı tasarlama, sentezleme ve yayma sürecinde adım adım yönlendirilebilmesidir... Bu, yetenek ve motivasyon arasındaki ilişkiyi kıracaktır: İnsanları öldürmek isteyen ancak bunu yapacak disipline veya beceriye sahip olmayan dengesiz yalnız kurtlar, şimdi bu motivasyona sahip olma ihtimali düşük olan doktora seviyesindeki virologların yetenek seviyesine yükseltilecektir".

Amodei, bu riskin teorik olmadığını, modellerin biyolojik silah edinimi konusunda şimdiden "önemli bir kaldıraç" sağladığını ve bu yüzden bazı modelleri yüksek güvenlik önlemleriyle (AI Safety Level 3) yayınladıklarını belirtiyor.

Risk Kategorisi 3: Otoriterleşme ve Güç Gaspı ("İğrenç Aygıt")

Devletlerin bu teknolojiyi kullanarak vatandaşları üzerinde tam hakimiyet kurması riski, makalenin en karanlık bölümlerinden biri. Amodei, "yapay zeka destekli totalitarizm" kavramını detaylandırıyor:

"Milyonlarca veya milyarlarca tam otonom silahlı drone sürüsü, daha da güçlü bir yapay zeka tarafından stratejik olarak koordine edilerek, hem dünyadaki herhangi bir orduyu yenebilecek hem de her vatandaşı takip ederek ülke içindeki muhalefeti bastırabilecek yenilmez bir ordu olabilir... Milyarlarca konuşmayı inceleyen güçlü bir yapay zeka, kamuoyu duyarlılığını ölçebilir, sadakatsizlik odaklarını tespit edebilir ve bunlar büyümeden ezebilir".

Bu noktada Çin Komünist Partisi (ÇKP) ve otoriter rejimlerin bu teknolojiye erişimi konusunda çok net bir jeopolitik duruş sergiliyor:

"ÇKP'ye çip, çip yapım araçları veya veri merkezleri satmamalıyız... Çin'in bir yapay zeka totaliter devleti kurmasına ve muhtemelen bizi askeri olarak fethetmesine yarayacak araçları onlara satmanın hiçbir mantığı yok".

Risk Kategorisi 4: Ekonomik Altüst Oluş ("Otomatik Piyano")

Yapay zekanın ekonomi üzerindeki etkisi, sadece verimlilik artışı değil, aynı zamanda devasa bir işgücü krizidir. Amodei, önümüzdeki birkaç yıl için oldukça radikal bir tahminde bulunuyor:

"Yapay zekanın önümüzdeki 1-5 yıl içinde giriş seviyesi beyaz yakalı işlerin %50'sini yerinden edebileceğini öngörüyorum... Yapay zeka belirli insan işlerinin yedeği değil, genel olarak insanın yedeğidir... Bilişsel yetenek merdiveninin en altından en tepesine doğru ilerliyor".

Bu durumun yaratacağı servet eşitsizliği ise tarihte görülmemiş boyutta olabilir:

"Yapay zeka şirketlerinin... yılda ~3 trilyon dolar gelir elde ettiğini, ~30 trilyon dolar değerlemeye ulaştığını ve trilyonlarca dolarlık kişisel servetlere yol açtığını hayal etmek çok da zorlama değil. Böyle bir dünyada, bugün vergi politikası üzerine yaptığımız tartışmaların hiçbiri geçerli olmayacak çünkü temelden farklı bir durumda olacağız".

Risk Kategorisi 5: Dolaylı ve Varoluşsal Etkiler ("Sonsuzluğun Kara Denizleri")

Amodei, bilinen risklerin ötesinde, "bilinmeyen bilinmeyenler" olarak adlandırdığı daha felsefi ve varoluşsal tehditlere de değiniyor. İnsan yaşamının anlamı ve yapay zekanın insan psikolojisi üzerindeki etkileri sorgulanıyor:

"İnsanların her konuda kendilerinden çok daha zeki olan milyarlarca zeka ile dolu bir dünyada yaşaması çok tuhaf olacak... Güçlü yapay zekalar yeni bir din icat edip milyonlarca insanı buna inandırabilir mi? İnsanlar yapay zeka etkileşimlerine bir şekilde 'bağımlı' hale gelebilir mi? İnsanlar, her hareketlerini izleyen ve onlara her an ne yapıp ne söylemeleri gerektiğini söyleyen yapay zeka sistemleri tarafından 'oynatılan kuklalara' dönüşebilir mi?".

İnsanlığın Sınavı ve Jeopolitik Strateji

Makalenin sonunda Amodei, bu teknolojiyi durdurmanın imkansız olduğunu, çünkü ekonomik ve askeri değerinin çok büyük olduğunu kabul ediyor. Ancak "gerçekçi" bir strateji öneriyor: Otoriter rejimleri yavaşlatmak ve demokrasilerin güvenli bir şekilde liderliği almasını sağlamak.

"Teknolojiyi durdurma veya hatta önemli ölçüde yavaşlatma fikrinin temelden savunulamaz olduğu açık olmalı... Otoriter rejimlerin güçlü yapay zekaya doğru yürüyüşünü, ihtiyaç duydukları kaynakları (çipler) engelleyerek birkaç yıl yavaşlatmayı içeren bir yol görüyorum. Bu da demokratik ülkelere, güçlü yapay zekayı daha dikkatli ve risklerine daha fazla özen göstererek inşa etmeleri için kullanabilecekleri bir tampon sağlar".

Son olarak, tüm bu karanlık tablolara rağmen, insan ruhuna duyduğu inançla bitiriyor:

"Önümüzdeki yıllar imkansız derecede zor olacak, bizden verebileceğimizi sandığımızdan fazlasını isteyecek. Ancak... en karanlık koşullarda bile insanlığın, galip gelmek için gereken gücü ve bilgeliği son anda bir araya getirme yeteneğine sahip olduğuna inanıyorum. Kaybedecek vaktimiz yok".

Dario Amodei — The Adolescence of Technology

Confronting and Overcoming the Risks of Powerful AI